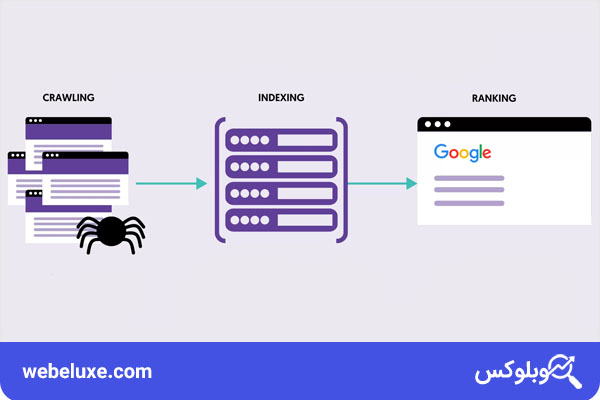

یکی از مباحث مهم در آموزش سئو، نحوه کار کردن موتورهای جستجو می باشد. نحوه کار کردن موتورهای جستجو به این شکل است که در ابتدا صفحات سایت شما را کراول (Crawl) می کنند، سپس اطلاعات کسب شده از این صفحات را در دیتابیس خود دخیره می کنند (Index) و نهایتا با توجه به جستجو کاربر آن ها را رتبه بندی (Rank) می کنند. اما اگر دوست دارید که با جزییات بیشتری بدانید که موتورهای جستجو چگونه کار می کنند در ادامه مقاله با ما همراه باشید.

موتور جستجو چیست؟

قبل از پرداختن به نحوه کار کردن موتورهای جستجو و اینکه موتورهای جستجو چگونه کار می کنند تعریفی از خود موتور جستجو (Search Engine) داشته باشیم. موتور جستجو مانند گوگل و یاهو، سیستمی است که کاربران می توانند اطلاعات مورد نظر خود را در اینترنت جستجو کنند. موتورهای جستجو بر اساس عبارات یا کلمات کلیدی که کاربر وارد می کند، صفحات وب را جستجو کرده و نتایجی که بیشترین تطابق را با این کلمات دارند نمایش می دهند.

نحوه کار کردن موتورهای جستجو اینگونه است که با استفاده از الگوریتم های پیچیده و ربات های خزنده (crawlers)، دائما وب سایت ها را بررسی کرده و در حال جمع آوری اطلاعات در مورد صفحات موجود در سایت های مختلف و ذخیره این اطلاعات در پایگاه داده خود هستند تا بتوانند بهترین و مرتبط ترین نتایج را بر اساس درخواست کاربران ارائه دهند. الگوریتم های این موتورها به گونهای طراحی شده اند که نتایج مرتبط تر و با کیفیت تر را در صدر فهرست نتایج قرار دهند.

نحوه کار کردن موتورهای جستجو : موتورهای جستجو چگونه کار می کنند؟

نحوه کار کردن موتورهای جستجو دارای ۳ بخش اصلی است:

- خزیدن (Crawl)

- ایندکس (index)

- رتبه بندی (Rank)

خزیدن (Crawl)

موتورهای جستجو دارای ربات ها یا خزنده هایی هستند که یک صفحه را از بالا تا پایین خط به خط کراول می کنند (crawl) و از این صفحات یکسری اطلاعات مانند نوع صفحه (content)، موضوع و کلمات کلیدی صفحه (keywords)، زمان آخرین آپدیت (Last Updated)، لینک های صفحه (Internal & External Link) و نوع رفتار کاربر با این صفحه (User Engagement) را بدست می آورند.

ایندکس (index)

در نحوه کار کردن موتورهای جستجو پس از کسب اطلاعاتی که در بالا ذکر شد، این صفحه را به همراه اطلاعات کسب شده در دیتابیس خود دخیره و یا به اصطلاح ایندکس می کنند. (Index)

رتبه بندی (Rank)

زمانی که کاربر یک عبارت را در موتورهای جستجو وارد می کند، نحوه کار کردن موتورهای جستجو اینگونه است که براساس الگوریتم هایشان و یکسری مشخصات از کاربر مانند مکان (Location)، زبان (Language)، نوع دستگاهی که با آن جستجو کرده (Device) و تاریخچه جستجوی کاربر (Search History)، صفحات ایندکس شده را رتبه بندی کرده (Rank) و به کاربر نمایش می دهند. به همین دلیل است که زمانی که ۲ کاربر از مکان های مختلف و حتی با دستکاه های مختلف مثلا یکی با موبایل و دیگری با لپ تاپ، یک عبارت را سرچ می کنند نتایج مختلفی برایشان نمایش داده می شود.

تاریخچه موتورهای جستجو

حال که با نحوه کار کردن موتورهای جستجو آشنا شدید خالی از لطف نیست که از تاریخچه به وجود آمدن موتورهای جستجو نیز اطلاعاتی داشته باشید. تاریخچه موتورهای جستجو به اواخر دهه ۱۹۸۰ و اوایل دهه ۱۹۹۰ برمیگردد. در این دوران، اینترنت به سرعت در حال گسترش بود و نیاز به ابزارهایی برای جستجوی اطلاعات موجود در وب احساس می شد.

موتورهای جستجوی آرچی (Archie) در سال ۱۹۹۰ اولین ابزار جستجو در اینترنت بود که توسط آلن ایمتیج در دانشگاه مک گیل در کانادا توسعه یافت. آرچی در واقع فهرستی از فایل های موجود در سرورهای FTP بود و امکان جستجو در نام فایل ها را فراهم می کرد.

موتورهای جستجوی بعدی، گوفر (Gopher) و ورونیکا (Veronica) در سال ۱۹۹۱- ۱۹۹۲ بودند. گوفر یک پروتکل برای توزیع، جستجو و بازیابی اطلاعات بود که توسط دانشگاه مینه سوتا ایجاد شد. ورونیکا ابزاری برای جستجو در پایگاه های داده گوفر بود.

در سال ۱۹۹۴ وبکرالر (WebCrawler) به عنوان اولین موتور جستجو که امکان جستجوی متنی کامل در صفحات وب را فراهم می کرد توسط برایان پینکرتون ساخته شد و محبوبیت زیادی پیدا کرد.

در ادامه در سال ۱۹۹۴ یاهو (Yahoo) ابتدا به عنوان یک فهرست وب (directory) شروع به کار کرد و سپس به یک موتور جستجو تبدیل شد. این سایت از اولین و معروف ترین خدمات جستجو در اوایل اینترنت بود.

در سال ۱۹۹۵ موتور جستجوی آلتاویستا (AltaVista) به عنوان یکی از پیشرفته ترین و محبوب ترین موتورهای جستجو در دهه ۹۰ با استفاده از تکنولوژی های جدید توانست نتایج جستجو را به سرعت و با دقت بالا ارائه دهد.

یکی دیگر از موتورهای جستجوی اولیه در سال ۱۹۹۵ که از تکنولوژی های پردازش زبان طبیعی و تجزیه و تحلیل لینک ها برای بهبود نتایج جستجو استفاده کرد، ایکسایت (Excite) بود.

بالاخره در سال ۱۹۹۸ موتور جستجوی گوگل (Google) توسط لری پیج و سرگئی برین تأسیس شد. الگوریتم رتبه بندی صفحه گوگل (Page Rank) که بر اساس تحلیل لینک ها عمل می کرد، توانست دقت و کیفیت نتایج جستجو را به طور چشمگیری افزایش دهد. گوگل به سرعت به پرکاربردترین موتور جستجو تبدیل شد و هنوز هم در صدر بازار قرار دارد.

نهایتا در سال ۲۰۰۹ بینگ (Bing) به عنوان موتور جستجوی مایکروسافت و جانشین MSN Search و Live Search عرضه شد و با رابط کاربری بهبود یافته و ویژگی های جدید، به رقابت با گوگل پرداخت.

این موتورهای جستجو هر کدام نقش مهمی در تکامل اینترنت و نحوه دستیابی به اطلاعات داشته اند. امروزه موتورهای جستجو بخش جدایی ناپذیری از زندگی روزمره کاربران اینترنت شده اند و به طور مداوم در حال بهبود و تکامل هستند تا تجربه کاربری بهتری ارائه دهند.

آیا اهمیت همه موتورهای جستجو در سئو یکسان است؟

حقیقت این است که با وجود حداقل بیست موتور جستجوی بزرگ در دنیا مانند بینگ و یاهو و نحوه کار کردن موتورهای جستجو به طور تقریبا یکسان، توجه جامعه سئو بر روی گوگل متمرکز است. مهمترین دلیلش این است که بیشتر جستجو های دنیا در گوگل انجام می شود. اگر ما علاوه بر بخش وب گوگل، بخش های تصاویر، نقشه و یوتیوب (تحت مالکیت گوگل) را نیز در نظر بگیریم، بیش از ۹۰٪ جستجوهای دنیا در گوگل رخ می دهد. این عدد ۲۰ برابر بیشتر از جمع سهم بینگ و یاهو می باشد.

ارزیابی محتوا توسط موتورهای جستجو چگونه است؟

به نقل از مدیر وب نحوه کار کردن موتورهای جستجو با محتوا و ارزیابی آن را را بیان می کنیم.

عنکبوتها برای ارزیابی محتوای صفحات، همه چیز را مورد بررسی قرار میدهند. آنها براساس کلمات به کار رفته شده در عنوان، زیرعنوانها و متن صفحه، به دنبال الگوهای مشخصی میگردند. آیا کلمه یا عبارتی خاص مرتبا تکرار شده است؟ مثلا اگر کلمه “شیر” تکرار قابل توجهی در محتوای صفحه دارد، پس احتمالا محتوا درباره سلطان جنگل است. اما اگر علاوه بر این، از کلسیم و استحکام استخوانها نیز صحبت شده باشد، پس محتوا درباره شیر پاستوریزه است.

اگر میخواهید کاربران صفحه “شیر پاستوریزه” شما را پیدا کنند، تنها بسنده کردن به این موضوع کافی نیست. اینکه موتورهای جستجو متوجه موضوع صفحه شما شوند، تنها بخشی از فرآیند لازم است. موتورهای جستجو حالا باید تعیین کنند که از بین تمام صفحات مربوط به شیر پاستوریزه، کدامها ارتباط بیشتری با کوئری کاربران دارند و کدامها را باید اول ارائه دهند.

نتایج جستجو به واسطه اعتبار و محبوبیت صفحات فهرست میشوند. فاکتورهای رتبهبندی بسیار پیچیده و دائما درحال تغییر هستند. اما چیزی که ثابت است، این است که همگی آنها رضایت کاربر را هدف قرار میدهند. فرض کنید شما کسی هستید که به دنبال اطلاعاتی درباره شیر پاستوریزه میگردید. بدون شک، بالاترین کیفیت، بیشترین دقت و کاملترین توضیحات را میخواهید. پس هرچه محتوای شما برای کاربران کاربردیتر باشد، به منزله این است که شما فاکتورهای بیشتری را رعایت کردهاید.

موتورهای جستجو کدام صفحات سایت شما را کراول می کنند؟

شما می توانید به کراولرها بگویید که کدام صفحات سایت شما را دسترسی داشته باشند و کروال کنند و کدام صفحات سایت را دسترسی نداشته باشند! مثلا صفحاتی که محتوای ضعیف دارند، دارای URLهای تکراری هستند (مانند پارامتر های مرتب سازی و فیلتر برای ای کامرس)، صفحات تبلیغاتی هستند و به طور کلی صفحاتی که نیاز نیست کاربر آن را ببند.

این عمل باعث می شود که نحوه کار کردن موتورهای جستجو و کراولرها در برابر سایت شما بهتر بوده و کراولرها بتوانند صفحات مهم سایت شما را اولویت بندی کنند و بودجه کراول کردن (Crawl Budget) در سایتتان افزایش یابد. منظور از بودجه کراول میانگین صفحه هایی است که ربات های موتور جستجو در هر بار که به سایت شما سر میزنند، بررسی می کنند. حال از ۳ طریق می توانید دسترسی ربات ها به صفحات سایتتان را مشخص کنید:

- به کمک فایل robots.txt

- با استفاده از سایت مپ (SiteMap)

- به کمک مگا تگ ها

فایل Robots.txt

در نحوه کار کردن موتورهای جستجو شما به کمک فایل robots.txt به کراولرها می گویید که به کدام قسمت از سایت دسترسی داشته باشند و کدام صفحات قسمت ها دسترسی نداشته باشند. بهترین راه برای مسدود کردن ربات ها از صفحات غیر خصوصی، استفاده از robots.txt است.

البته این نکات را نیز در نظر داشته باشید که اگر ربات گوگل نتواند فایل robots.txt را پیدا کند به کراول کردن سایت ادامه می دهد. اگر ربات گوگل فایل robots.txt را پیدا کند اغلب از دستورات پیروی می کند و طبق دستورات به کراول کردن سایت می پردازد.

سایت مپ

سایت مپ لیستی از URLها است که به کراولر ها می گوید کجای سایت را کشف و ایندکس کنند. ساده ترین راه برای اطمینان داشتن از اینکه آیا گوگل صفحات پر اهمیت شما را پیدا می کند این است که یک فایل تقشه سایت با استاندارد های گوگل ایجاد کنید و آن را در سرچ کنسول ثبت کنید. ارسال نقشه سایت نیاز سایت را به یک رابط کاربری و ناوبری تمیز از بین نمی برد اما مطمئنا به کراولر ها مسیر صفحات مهم را نشان می دهد.

دستورات متا

در نحوه کار کردن موتورهای جستجو شما به کمک تگ noindex نیز می توانید دسترسی ربات ها به صفحات سایت خود را محدود کنید. با بکارگیری تگ noindex در قسمت <head> به کراولرها می گویید که این صفحه نیازی به ایندکس شدن ندارد پس کروال هم نشود. دقت کنید که در وردپرس در قسمت داشبورد> تنظیمات> خواندن مطمئن شوید تیک مربوط به «قابلیت مشاهده موتور جستجو» را زده اید، در غیر این صورت موتورهای جستجو از ایندکس کردن سایت شما به دلیل وجود فایل robots.txt صرف نظر می کنند.

بعد از اینکه سایت شما توسط کراولر ها بررسی شد قدم بعدی این است که مطمئن شوید محتوای شما ایندکس می شوند. به کمک دستور site:yourdomian می توانید صفحاتی از سایت خود را که در گوگل ایندکس شده اند مشاهده کنید.

سخن پایانی

در این مقاله در مورد نحوه کار کردن موتورهای جستجو و اینکه موتورهای جستجو چگونه کار می کنند به طور کامل و جامع صحبت کردیم. دانستن این موارد به شما در درک عمیق سئو و بهینه سازی سایت کمک می کند و باعث می شود که در رفع مشکلات سایت بهتر عمل کنید.

اگر این مقاله براتون مفید بود، آن را با دیگران به اشتراک بگذارید تا آن ها نیز از این اطلاعات بهره مند شوند. در صورتی که سوال یا نظری دارید، در قسمت نظرات، آن را با ما به اشتراک بگذارید. با تشکر از شما.